Sztuczna inteligencja w tworzeniu oprogramowania. Mierzalna korzyść, czy chwilowy trend?

Sztuczna inteligencja zmienia sposób, w jaki tworzymy oprogramowanie. W ciągu ostatnich dwóch lat zespoły inżynierskie zostały zalane nowymi narzędziami, które obiecują automatyzację, przyspieszenie i usprawnienie każdego etapu cyklu życia oprogramowania. Pytanie nie brzmi już, czy AI jest wykorzystywana w inżynierii oprogramowania, lecz czy rzeczywiście dzięki niej programiści i organizacje stają się bardziej produktywni?

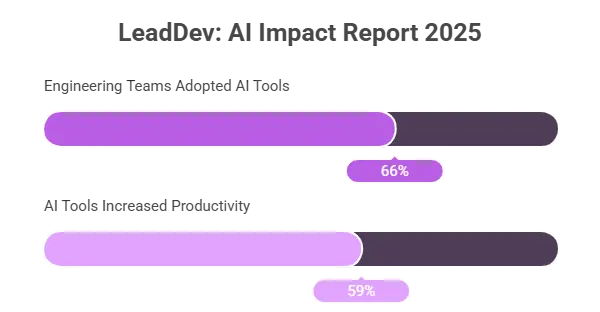

Dane są obiecujące, choć złożone. Według raportu LeadDev AI Impact Report 2025, 66% zespołów inżynierskich już wdrożyło narzędzia AI w środowisku produkcyjnym, a 59% twierdzi, że dzięki nim są bardziej produktywni [1]. Z kolei Gartner prognozuje, że do 2028 roku ponad 80% oprogramowania korporacyjnego będzie zawierać funkcje oparte na generatywnej AI [2]. Tymczasem McKinsey szacuje, że sztuczna inteligencja może generować nawet do 4,4 biliona dolarów rocznie w globalnych zyskach z produktywności, przy czym rozwój oprogramowania znajduje się wśród głównych beneficjentów tego wzrostu [3].

AI w tworzeniu oprogramowania: asystenci kodowania

Spośród wszystkich innowacji napędzanych przez sztuczną inteligencję, asystenci kodowania wywarli najbardziej widoczny wpływ na codzienną pracę. Związek między AI a inżynierią oprogramowania staje się coraz ściślejszy — uczenie maszynowe przekształca i usprawnia procesy tworzenia oprogramowania. Narzędzia takie jak Cursor, GitHub Copilot, Claude, Tabnine i CodeWhisperer redefiniują znaczenie pisania kodu.

Cursor obecnie przoduje pod względem wdrożeń korporacyjnych — korzysta z niego 45% zespołów objętych badaniem LeadDev [1]. W przeciwieństwie do wcześniejszych silników autouzupełniania, Cursor rozumie kontekst projektu — potrafi przeszukiwać pliki, inteligentnie refaktoryzować kod oraz generować spójne fragmenty kodu zgodne z zasadami architektury. Jako rozwiązanie oparte na AI, Cursor automatyzuje i demokratyzuje proces tworzenia oprogramowania, umożliwiając zarówno użytkownikom technicznym, jak i nietechnicznym budowanie zaawansowanych aplikacji wspieranych przez sztuczną inteligencję. Eliminuje znaczną część powtarzalnych zadań i kodu szablonowego, które wcześniej pochłaniały czas programistów. Specjalista może teraz w kilka minut stworzyć to, co kiedyś zajmowało godziny. Ta zmiana pozwala zespołom deweloperskim poświęcać więcej uwagi złożonym problemom, takim jak optymalizacja czy integracja systemów.

GitHub Copilot pozostaje punktem odniesienia dla całej branży. Zbudowany w oparciu o zaawansowane algorytmy uczenia maszynowego, wytrenowane na miliardach linii publicznego kodu, oferuje niezwykle trafne podpowiedzi i uzupełnienia kodu na podstawie opisów w języku naturalnym. Copilot zrewolucjonizował proces pisania kodu, zapewniając autouzupełnianie, wykrywanie błędów i generowanie kodu, co znacząco zwiększa produktywność programistów. Organizacje korzystające z Copilota raportują wymierne rezultaty: 25–35% wzrost prędkości pracy zespołów deweloperskich i 20% redukcję czasu poświęcanego na debugowanie. Te liczby nie tylko robią wrażenie — zmieniają sposób planowania projektów i rekrutacji. Zespoły mogą teraz mierzyć efektywność nie w godzinach kodowania, lecz w przepustowości i kreatywności.

Claude, duży model językowy opracowany przez Anthropic, reprezentuje kolejny etap ewolucji AI w tworzeniu oprogramowania. Zamiast generować kod linia po linii, Claude rozumie całe repozytoria. Czyta dokumentację, komentarze i historię projektu, aby proponować refaktoryzacje i wyjaśniać logikę systemu. Na przykład w jednym środowisku badawczo-rozwojowym Claude przeanalizował 80 000 linii kodu legacy, streszczając zależności architektoniczne i identyfikując potencjalne wąskie gardła wydajności — wszystko w mniej niż godzinę, podczas gdy programista potrzebowałby na to kilku dni. Narzędzia takie jak Claude pomagają również wykrywać i naprawiać błędy w kodzie, poprawiając jego jakość i usprawniając przepływ pracy. To sprawia, że Claude jest szczególnie przydatny dla organizacji utrzymujących duże, złożone systemy lub szybko wdrażających nowych deweloperów.

Tabnine i CodeWhisperer skupiają się na bezpieczeństwie i zgodności w środowiskach korporacyjnych. Tabnine działa lokalnie lub w prywatnych chmurach, dzięki czemu wrażliwy kod nigdy nie opuszcza infrastruktury firmy, natomiast CodeWhisperer integruje się bezpośrednio z ekosystemem AWS, generując funkcje dopasowane do usług chmurowych. Oba narzędzia potrafią tworzyć całe funkcje na podstawie opisów w języku naturalnym, automatyzując kolejne etapy procesu kodowania. Pokazują one, jak asystenci AI dostosowują się do realiów biznesowych, w których ochrona własności intelektualnej jest równie istotna jak produktywność.

Te narzędzia zmieniają układ sił w procesie tworzenia oprogramowania. Wspierają programistów poprzez automatyzację generowania kodu, sugerowanie fragmentów i usprawnianie przepływu pracy. Zamiast poświęcać czas na powtarzalne zadania, inżynierowie koncentrują się na architekturze, bezpieczeństwie i innowacjach. W pewnym sensie redefiniują oni istotę inżynierii oprogramowania. Wprowadzenie generatywnej sztucznej inteligencji do codziennej pracy stanowi największą zmianę paradygmatu od czasów upowszechnienia chmury obliczeniowej — a jej skutki dopiero zaczynają się ujawniać.

Narzędzia AI, które wzmacniają jakość

Zapewnienie jakości stanowi fundament procesu tworzenia oprogramowania — a sztuczna inteligencja cicho, lecz skutecznie go rewolucjonizuje. Testowanie, które niegdyś wymagało zespołów ręcznych testerów lub skomplikowanych skryptów, dziś może być w dużej mierze zautomatyzowane dzięki narzędziom opartym na AI, które uczą się i doskonalą z każdą iteracją. Sztuczna inteligencja doskonale radzi sobie z automatyzacją powtarzalnych zadań, takich jak tworzenie i wykonywanie przypadków testowych, co znacząco zwiększa efektywność i pozwala zespołom QA skupić się na bardziej złożonych problemach.

Rozwiązania takie jak Testim, Mabl, CodeRabbit czy Amazon Q wykorzystują modele uczenia maszynowego do identyfikowania wzorców w danych historycznych i tworzenia dynamicznych przypadków testowych. Zamiast polegać wyłącznie na testach pisanych przez ludzi, AI nieustannie dostosowuje zakres testowania na podstawie rzeczywistych zachowań użytkowników. Dzięki temu kluczowe przypadki brzegowe są wykrywane wcześniej w cyklu rozwoju. Według badań LeadDev, 57% organizacji wdrożyło już AI w procesach QA, a 23% z nich zgłasza zmniejszenie długu technologicznego po wdrożeniu takich rozwiązań [1].

CodeRabbit łączy generatywną sztuczną inteligencję z automatycznymi przeglądami kodu, aby wykrywać potencjalne luki bezpieczeństwa i błędy logiczne jeszcze przed wdrożeniem. Narzędzie to nie tylko wskazuje problemy, ale również rekomenduje sposoby refaktoryzacji kodu i może automatycznie generować skrypty testowe dla nowo wprowadzonych funkcji. Firmy, które zastosowały rozwiązania AI w QA, odnotowały do 35% szybsze testy regresyjne oraz 20% spadek liczby błędów po wdrożeniu. Mabl i Testim uzupełniają ten proces dzięki tzw. self-healing tests — testom samonaprawiającym się, które automatycznie aktualizują się w przypadku zmian w interfejsie użytkownika lub strukturze API, ograniczając koszty utrzymania.

Co więcej, nowoczesne narzędzia oparte na AI integrują analizy predykcyjne. Potrafią one oszacować prawdopodobieństwo, że nowa wersja oprogramowania spowoduje spadek wydajności lub wprowadzi nowe błędy. Analizując dane historyczne, umożliwiają zespołom deweloperskim planowanie wdrożeń z większą pewnością. Takie ulepszenia nie tylko podnoszą jakość oprogramowania — całkowicie zmieniają podejście do zarządzania ryzykiem. Proces tworzenia oprogramowania staje się proaktywny, a nie reaktywny. Dla organizacji działających na dużą skalę ta automatyzacja przekłada się bezpośrednio na mniej awarii, wyższą satysfakcję klientów i niższe koszty operacyjne. Dzięki usprawnieniu i wzmocnieniu procesów rozwoju, integracja AI sprawia, że testowanie i QA stają się bardziej wydajne i skuteczne na każdym etapie cyklu życia oprogramowania.

Zarządzanie projektami i koordynacja inżynierii

Sztuczna inteligencja zmienia również sposób, w jaki organizacje inżynierskie planują i koordynują pracę. Zarządzanie projektami nie polega już na statycznych pulpitach i ręcznych aktualizacjach. Współczesne narzędzia oparte na AI — takie jak LinearB, Asana Intelligence czy pakiet automatyzacji AI w Jira — analizują dane z commitów, branchy i zgłoszeń, aby dostarczać predykcyjne informacje i praktyczne wnioski. Dzięki analizie danych użytkowników, narzędzia te pozwalają jeszcze lepiej planować i koordynować projekty, zapewniając zespołom dostęp do najbardziej aktualnych i użytecznych informacji.

Wyobraź sobie możliwość prognozowania prędkości sprintu nie na podstawie szacunków, lecz dzięki uczeniu maszynowemu. AI potrafi wskazać, gdzie tworzą się wąskie gardła, które pull requesty utknęły, a nawet gdzie występują luki komunikacyjne między zespołami. Według prognoz Gartnera, do 2026 roku aż 70% organizacji programistycznych będzie wykorzystywać AI do podejmowania decyzji dotyczących planowania projektów [2]. Ten poziom wglądu zmienia zarządzanie projektami w proces oparty na danych i ciągłej optymalizacji.

Analityka wspierana przez AI poprawia również prognozowanie strategiczne. Niektóre organizacje wykorzystują AI do modelowania wpływu zmian w wymaganiach projektowych w trakcie cyklu rozwoju. Poprzez symulację procesu wytwarzania oprogramowania, narzędzia AI potrafią przewidzieć opóźnienia w dostawach lub niedobory zasobów zanim do nich dojdzie, co umożliwia zespołom proaktywne dostosowywanie priorytetów.

Wdrożenie sztucznej inteligencji w zarządzaniu projektami wciąż znajduje się na wczesnym etapie, ale jej potencjał jest wyraźny: mniej opóźnień, mniej wypalenia zawodowego i bardziej przejrzysta współpraca między działami.

Dane, analityka i wsparcie decyzyjne

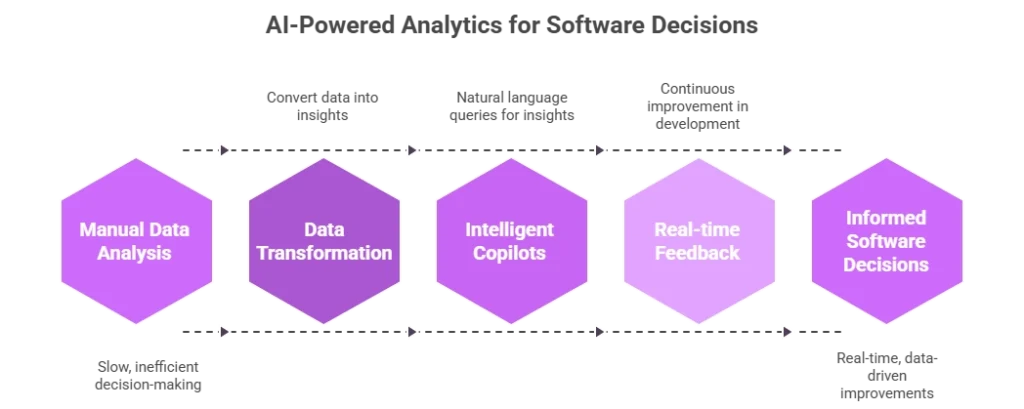

Rola sztucznej inteligencji w inżynierii oprogramowania wykracza daleko poza edytor kodu. Narzędzia analityczne zasilane przez AI zmieniają sposób, w jaki liderzy podejmują decyzje dotyczące produktów i infrastruktury. Platformy takie jak Databricks, Glean czy Perplexity AI wykorzystują uczenie maszynowe i przetwarzanie języka naturalnego (NLP), aby przekształcać ogromne strumienie danych technicznych w praktyczne, użyteczne wnioski. Rozwój i wdrażanie tych narzędzi opartych na AI w dużej mierze zależy od języków programowania, które stanowią fundament implementacji i optymalizacji modeli sztucznej inteligencji w tych platformach.

Przykładowo, analityka wspierana przez AI potrafi powiązać zachowania użytkowników z wydajnością systemu, pomagając zespołom ustalać priorytety optymalizacji, które realnie poprawiają doświadczenie użytkownika. W jednym z projektów fintechowych modele AI analizujące wzorce korzystania z aplikacji przez klientów doprowadziły do redukcji niepotrzebnych obciążeń obliczeniowych o 18%, co przełożyło się na niższe koszty infrastruktury i krótszy czas odpowiedzi systemu.

Google Gemini i OpenAI GPT-4 Turbo idą o krok dalej, pełniąc rolę inteligentnych asystentów w procesie decyzyjnym. Pozwalają zespołom zadawać pytania dotyczące logów, incydentów czy danych telemetrycznych w języku naturalnym — łącząc świat techniczny i biznesowy. Zamiast ręcznego przeszukiwania metryk, liderzy mogą zapytać: „Jak zmieniło się opóźnienie wdrożenia po ostatnim release?” i natychmiast otrzymać wizualną, czytelną odpowiedź.

Rosnąca rola systemów AI w analityce sprawia, że decyzje dotyczące oprogramowania są dziś oparte na bieżących pętlach informacji zwrotnych. Umożliwia to ciągłe doskonalenie w całym cyklu życia oprogramowania i podkreśla znaczenie integracji AI na każdym etapie procesu rozwoju.

Integracja i bezpieczeństwo

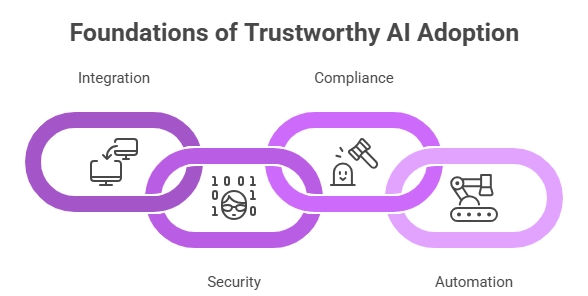

Choć integracja i bezpieczeństwo rzadko trafiają na pierwsze strony branżowych publikacji, stanowią fundament zaufanego wdrażania AI. Wiele firm wciąż nie docenia ryzyka związanego z używaniem kodu generowanego przez sztuczną inteligencję bez odpowiedniej walidacji. W miarę jak AI staje się coraz bardziej zintegrowana z codziennymi procesami, zapewnienie zgodności i ochrona własności intelektualnej stają się priorytetem. Odpowiednio włączona w proces tworzenia oprogramowania AI może zwiększyć produktywność, poprawić bezpieczeństwo i przyspieszyć realizację projektów dzięki automatyzacji zadań takich jak przegląd kodu czy debugowanie.

Narzędzia takie jak GitLab Duo, Amazon Bedrock czy n8n wspierają zarządzanie zgodnością i nadzorem, skanując repozytoria kodu pod kątem luk bezpieczeństwa i kontrolując dostęp do modeli AI. Technologie te oferują warstwy obserwowalności, które śledzą, co, kiedy i w jakim kontekście generują modele AI — co jest kluczowe w branżach regulowanych.

Z kolei LangChain i Zapier AI koncentrują się na integracji systemów, umożliwiając płynne połączenia między komponentami AI a tradycyjną infrastrukturą oprogramowania. Automatyzują one powtarzalne zadania, takie jak synchronizacja danych, generowanie raportów czy wdrażanie kodu, zwalniając programistów z rutynowych obowiązków. Przy prawidłowym wykorzystaniu redukują błędy ludzkie i zwiększają stabilność systemów.

Sztuczna inteligencja w obszarze bezpieczeństwa oprogramowania rozwija się równie dynamicznie. Narzędzia potrafią już monitorować repozytoria pod kątem przypadkowo ujawnionych kluczy dostępu czy niebezpiecznych zależności, które mogły zostać wprowadzone przez AI-generated code. Taka warstwa automatyzacji pomaga utrzymać zgodność z normami ISO 27001 czy SOC 2, bez dodatkowego obciążenia dla zespołów IT.

Rola outsourcingu i R&D

Skuteczne wdrożenie narzędzi AI wymaga wiedzy z zakresu informatyki, uczenia maszynowego oraz praktycznej inżynierii oprogramowania. Wiele organizacji nie dysponuje taką kombinacją kompetencji wewnętrznie — szczególnie w sytuacji szybkiego skalowania działalności. Właśnie tutaj pojawia się rola outsourcingu i wzmocnienia zespołów badawczo-rozwojowych (R&D staff augmentation), które umożliwiają firmom wykorzystanie najnowszych technologii, takich jak AI, w procesie tworzenia oprogramowania.

Współpraca z doświadczonymi zespołami zajmującymi się rozwojem AI pozwala firmom przyspieszyć wdrożenia bez przeciążania wewnętrznych struktur. Takie partnerstwa są szczególnie cenne przy integracji narzędzi opartych na AI z systemami legacy lub przy tworzeniu zasad nadzoru nad procesami, w których sztuczna inteligencja wspiera przeglądy kodu i testowanie.

Dzięki współpracy z zewnętrznymi specjalistami organizacje mogą automatyzować powtarzalne zadania, poprawiać jakość kodu i skracać cykle wdrożeniowe, zachowując jednocześnie pełną kontrolę nad strategią biznesową. Model działania jest prosty: zewnętrzni eksperci projektują i integrują systemy AI, podczas gdy zespoły wewnętrzne koncentrują się na innowacjach i tworzeniu przewagi konkurencyjnej. To hybrydowe podejście stało się już najlepszą praktyką w zakresie wdrażania AI w procesie tworzenia oprogramowania.

Od generatywnej do kognitywnej sztucznej inteligencji

Następna faza rozwoju sztucznej inteligencji przeniesie nas od systemów generatywnych do kognitywnych. Będą to narzędzia, które nie tylko generują kod, ale również rozumieją intencję stojącą za nim, pokazując zdolność AI do wykonywania bardziej złożonych zadań inżynieryjnych, takich jak projektowanie na wysokim poziomie, refaktoryzacja czy debugowanie. Cursor już dziś ilustruje ten kierunek, ucząc się na podstawie nawyków programistów i zwiększając swoją precyzję z czasem. Claude potrafi z kolei interpretować zasady architektury systemu i sugerować ulepszenia zgodne z celami w zakresie wydajności i skalowalności.

Według prognoz Gartnera, do 2030 roku środowiska oparte na AI zautomatyzują 70% rutynowych zadań programistycznych [2]. Z kolei McKinsey przewiduje, że w pełni zintegrowane platformy generatywnej AI skrócą czas wprowadzania oprogramowania na rynek o 30% [3]. W połączeniu z modelami uczenia maszynowego zdolnymi do ciągłej sam optymalizacji, technologie te sprawią, że proces tworzenia oprogramowania stanie się bardziej adaptacyjny i samokorygujący.

Rezultat? Szybsza innowacja i większa odporność systemów, ale także nowe wyzwania — branża będzie musiała dostosować się do zmieniających się procesów pracy i na nowo zdefiniować rolę inżyniera oprogramowania.

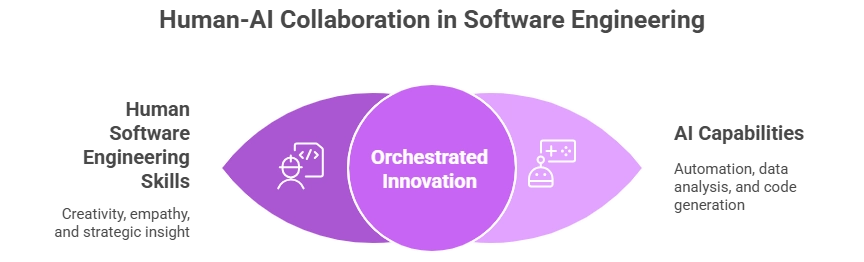

Czynnik ludzki nadal niezastąpiony

Nawet jeśli sztuczna inteligencja automatyzuje procesy tworzenia i testowania oprogramowania, ludzka kreatywność i myślenie krytyczne wciąż stoją w centrum. Programiści ewoluują w kierunku roli projektantów systemów i orkiestratorów AI – specjalistów skupionych na rozwiązywaniu problemów, projektowaniu architektury oraz etycznym nadzorze nad technologią. Unikalne umiejętności analityczne, kreatywność oraz głębokie zrozumienie potrzeb użytkowników, jakie posiadają inżynierowie oprogramowania, są czymś, czego sztuczna inteligencja nie jest w stanie w pełni odtworzyć.

Nowa era inżynierii oprogramowania będzie nagradzać zespoły łączące wiedzę techniczną z myśleniem strategicznym. Ostatecznie, możliwości AI w zakresie wspomagania decyzji i generowania kodu będą tak silne, jak ludzie, którzy je nadzorują.

Perspektywy na przyszłość: od narzędzi do transformacji

Kierunek jest jasny: narzędzia AI przestają być odrębnymi asystentami – stają się elementami zintegrowanych ekosystemów. Przyszłe środowiska IDE będą zawierać wbudowane moduły AI do debugowania, testowania, wdrażania i tworzenia dokumentacji, czyniąc cały proces rozwoju oprogramowania ciągłym i inteligentnym.

Wzrośnie również znaczenie zgodności i przejrzystości działania AI. Narzędzia testujące oparte na sztucznej inteligencji będą potrafiły uzasadniać swoje wyniki, a modele generatywne będą przechowywać wersjonowane łańcuchy rozumowania, co umożliwi pełny audyt decyzji podejmowanych przez AI. Usprawnienia te sprawią, że sztuczna inteligencja stanie się nie tylko szybsza, ale też bezpieczniejsza w zastosowaniach korporacyjnych.

Na rynku inżynierii oprogramowania pojawią się również nowe role zawodowe: architekci systemów AI, specjaliści ds. etyki danych czy inżynierowie promptów. Rynek pracy nie skurczy się – przeciwnie, ulegnie transformacji. AI eliminuje powtarzalne zadania o niskiej wartości, ale jednocześnie zwiększa zapotrzebowanie na zaawansowane myślenie, projektowanie architektury i współpracę interdyscyplinarną. W efekcie AI nie zastąpi ludzi – zdefiniuje na nowo pojęcie produktywności.

Zakończenie: jak przekształcić potencjał w wymierny efekt

Sztuczna inteligencja w procesie tworzenia oprogramowania nie jest już koncepcją teoretyczną — jej wpływ da się zmierzyć. Od generowania kodu, przez automatyzację QA, po analitykę i zarządzanie projektami — narzędzia AI udowodniły, że potrafią usprawniać przepływy pracy i podnosić jakość oprogramowania. Cursor, Copilot i Claude to przykłady, jak sztuczna inteligencja potrafi wzmocnić ludzki talent, a nie go zastąpić.

Wyzwania przyszłości koncentrują się wokół zarządzania, pomiaru efektów i integracji. Organizacje muszą opracować jasne ramy pomiarowe i odpowiedzialne zasady wdrażania AI. To właśnie połączenie systemów AI, algorytmów uczenia maszynowego i ludzkiego nadzoru zdecyduje o tym, czy sztuczna inteligencja stanie się trwałą przewagą konkurencyjną, czy tylko przemijającym trendem.

Transition Technologies PSC wspiera przedsiębiorstwa w tej transformacji, pomagając odpowiedzialnie integrować sztuczną inteligencję z działaniami badawczo-rozwojowymi i procesami inżynierii oprogramowania. Poprzez outsourcing, wzmocnienie zespołów R&D i implementacje dedykowanych rozwiązań AI, pomagamy klientom efektywnie wykorzystywać potencjał sztucznej inteligencji, automatyzować powtarzalne zadania oraz tworzyć skalowalne i bezpieczne rozwiązania, które poprawiają jakość oprogramowania bez zwiększania jego złożoności.

AI nie sprawia, że programiści stają się zbędni — czyni ich niezastąpionymi w nowym, opartym na danych świecie kreatywności i wydajności. To właśnie jest prawdziwa rewolucja produktywności — tworzenie oprogramowania mądrzej, szybciej i lepiej.

Źródła:

[1] LeadDev, AI Impact Report 2025

[2] Gartner, Generative AI Predictions 2024–2028

[3] McKinsey & Company, State of AI 2024 and The Economic Potential of Generative AI